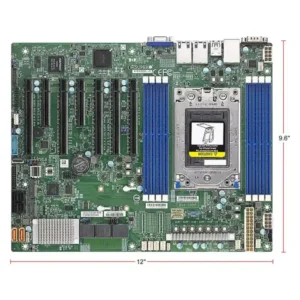

A+ Server AS-4145GH-TNMR คือเซิร์ฟเวอร์ประสิทธิภาพสูงระดับองค์กร ที่ออกแบบมาเพื่อรองรับงานประมวลผล AI และ HPC ที่ต้องการทั้งพลังการประมวลผลที่หนาแน่นและระบบจัดการที่ยืดหยุ่น เซิร์ฟเวอร์รุ่นนี้มาพร้อม โปรเซสเซอร์ AMD Instinct™ MI300A จำนวน 4 ตัว และหน่วยความจำ HBM3 ขนาดรวม 512GB แบบ Unified Memory Architecture บนบอร์ด รองรับการเชื่อมโยง GPU-GPU ผ่าน AMD Infinity Fabric™ และการทำงานแบบมัลติสเกลใน AI, ML, LLM หรือ Simulation ได้อย่างมีประสิทธิภาพ

ด้วยการรองรับ PCIe 5.0 สูงสุด 8 ช่อง, ตัวเลือกช่องใส่ไดรฟ์ได้สูงสุดถึง 24 ช่อง และระบบระบายความร้อนด้วยพัดลม 10 ตัว AS-4145GH-TNMR เป็นโซลูชันที่สมบูรณ์แบบสำหรับศูนย์ข้อมูลและ Edge AI Infrastructure

🔧 คุณสมบัติเด่น:

✅ ใช้ APU AMD Instinct™ MI300A จำนวน 4 ตัว บน Quad-Socket SH5 (TDP สูงสุด 760W ต่อชิป)

✅ หน่วยความจำ HBM3 ขนาดรวม 512GB (non-ECC, unified memory)

✅ รองรับ PCIe 5.0 x16 ได้สูงสุด 8 สล็อต (ขึ้นอยู่กับการกำหนดค่า)

✅ ช่องเสียบ AIOM สูงสุด 2 ช่อง รองรับ OCP NIC 3.0

✅ M.2 NVMe/SATA 2 ช่อง (M-Key 2280/22110)

✅ ช่องใส่ไดรฟ์ 2.5″ ด้านหน้า รองรับทั้ง NVMe และ SAS/SATA สูงสุด 24 ช่อง

✅ พัดลม 10 ตัวแบบหมุนสวนทาง พร้อม Air Shroud สำหรับควบคุมการไหลเวียนอากาศ

✅ แหล่งจ่ายไฟ Titanium 2700W 4 ชุดแบบ Redundant (3+1)

✅ ระบบจัดการระดับองค์กร: SuperCloud Composer®, SSM, SUM, TAS

✅ ความปลอดภัยระดับองค์กร: TPM 2.0, RoT, Secure Boot, Firmware Signing, Remote Attestation

🎯 เหมาะสำหรับงาน:

- AI Model Training / Inference (รวมถึง LLMs และ Multimodal AI)

- Simulation สำหรับอุตสาหกรรม, GenAI, Molecular Dynamics

- HPC Workload, Scientific Computing, Edge Datacenter

- ระบบความปลอดภัย, วิทยาศาสตร์ข้อมูล, การแพทย์ขั้นสูง

รีวิว

ยังไม่มีบทวิจารณ์